对于两个离散随机变量 X 和 Y,其联合熵定义为:

H(X,Y)=−x∈RX∑y∈RY∑P(x,y)logP(x,y)

其中 P(x,y) 为 X 和 Y 的联合概率密度函数。

上述公式的计算是通过将 X 和 Y 的所有可能取值组成的信息熵的期望值。

条件熵量化一个随机变量 Y 的结果与另一个随机变量 X 的结果之间的不确定性

对于离散随机变量 X 和 Y,其条件熵定义为:

H(Y∣X)=−x∈RX∑y∈RY∑P(x,y)logP(y∣x)

其中 P(y∣x) 为 Y 在给定 X 的情况下的概率密度函数。

考虑是随机变量,因此有 Naive Bayes:

P(y∣x)P(x)P(y∣x)=P(x)P(x,y)=P(x,y)

H(Y∣X)≡x∈RX∑P(x)H(Y∣X=xi)=−x∈RX∑P(x)y∈RY∑P(y∣x)logP(y∣x)=−x∈RX∑y∈RY∑P(x)P(y∣x)logP(y∣x)=−x∈RX∑y∈RY∑P(x,y)logP(y∣x)=−E[logP(Y∣X)]

如果做更多改写,则有:

H(Y∣X)∵∴≡x∈RX∑P(x)H(Y∣X=xi)=−x∈RX∑y∈RY∑P(x,y)logP(y∣x)=−x∈RX∑y∈RY∑P(x,y)logP(x)P(x,y)=−x∈RX∑y∈RY∑P(x,y)[logP(x,y)−logP(x)]=−x∈RX∑y∈RY∑P(x,y)logP(x,y)+x∈RX∑y∈RY∑P(x,y)logP(x)y∈RY∑P(x,y)=P(x)=−x∈RX∑y∈RY∑P(x,y)logP(x,y)+x∈RX∑P(x)logP(x)=H(X,Y)−H(X)

因此我们可以得出

H(Y∣X)H(X∣Y)=H(X,Y)−H(X)=H(X,Y)−H(Y)

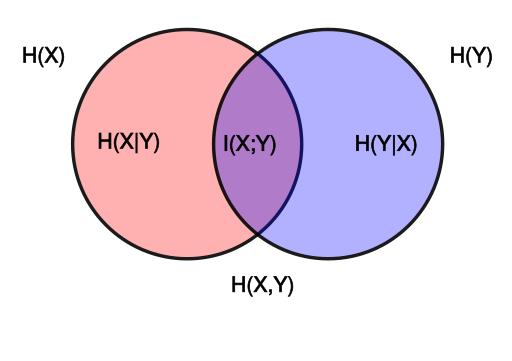

通过类似运算,我们可以获得如下韦恩图:

[https://commons.wikimedia.org/w/index.php?curid=11245361]

[https://commons.wikimedia.org/w/index.php?curid=11245361]

相对熵又叫 KL 散度,是衡量两个概率分布之间的差异性(或者说距离)。

我们假定两个相对于离散随机变量 X 的概率分布 P(x), Q(x)。对于这两个概率分布,每一个概率都有 ∑x∈RXP(x)=1 和 ∑x∈RXQ(x)=1,且 P(x)>0 和 Q(x)>0。

其相对熵定义为:

DKL(P∥Q)=x∈RX∑P(x)logQ(x)P(x)=E[logQ(x)P(x)]

考虑是对两个概率比值的期望值,因此有:

DKL≥0

当且仅当两个概率密度相等时,相对熵为 0。

DKL=E[logQ(x)P(x)]=E[logP(x)P(x)]=E[log1]=0

需要注意的是由于过程中是 P(x) 和 Q(x) 的比值,且存在 log 函数,因此相对熵不是对称的。即

DKL(P∥Q)=DKL(Q∥P)

而为了解决不对称的问题,我们可以使用 JSD 散度:

DJSD(P∥Q)=21DKL(P∥M)+21DKL(Q∥M)=21x∈RX∑P(x)logM(x)P(x)+21x∈RX∑Q(x)logM(x)Q(x)

其中 M(x)=2P(x)+Q(x)。这一节将不会详细讨论 JSD 散度。

对于随机变量 X 和 Y,其互信息定义为:

I(X;Y)=x∈RX∑y∈RY∑P(x,y)logP(x)P(y)P(x,y)

考虑 KL 散度的定义:

DKL(P∥Q)=x∈RX∑P(x)logQ(x)P(x)

如果我们将 P(x) 替换为 P(X,Y),Q(x) 替换为 P(X)P(Y) 则有:

==DKL(P(X,Y)∥P(X)P(Y))x∈RX∑P(X,Y)logP(X)P(Y)P(X,Y)I(X;Y)

因此我们可以认为互信息是 P(X)P(Y) 和 P(X,Y) 之间的距离。因此如果 X 和 Y 相互独立,P(X)P(Y)=P(X,Y),则互信息为 0。即:

I(X;Y)=DKL(P(X,Y)∥P(X)P(Y))=0

互信息也可以通过条件熵来表示:

考虑 Naive Bayes:

P(X∣Y)=P(Y)P(X,Y)

I(X;Y)∵∴=x∈RX∑y∈RY∑P(x,y)logP(x)P(y)P(x,y)P(x,y)=P(x∣y)P(y)=x∈RX∑y∈RY∑P(x,y)logP(x)P(y)P(x∣y)P(y)=x∈RX∑y∈RY∑P(x,y)logP(x)P(x∣y)=x∈RX∑y∈RY∑P(y)P(x∣y)logP(x)P(x∣y)=y∈RY∑P(y)x∈RX∑P(x∣y)logP(x)P(x∣y)=y∈RY∑P(y)DKL(P(X∣Y)∥P(X))=EY{DKL(P(X∣Y)∥P(X))}

因此我们获得了

I(X;Y)=EY{DKL(P(X∣Y)∥P(X))}

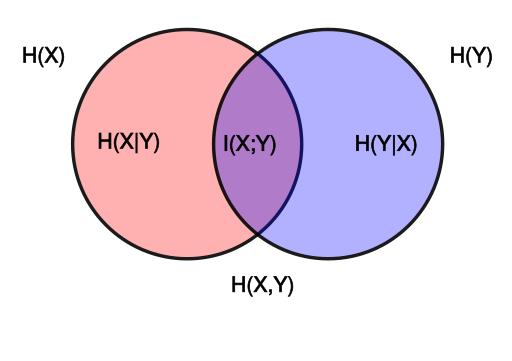

因此我们可以通过多种方式表达互信息:

I(X;Y)=H(X)−H(X∣Y)=H(Y)−H(Y∣X)=H(X)+H(Y)−H(X,Y)=H(X,Y)−H(X∣Y)−H(Y∣X)=EY{DKL(P(X∣Y)∥P(X))}

[https://commons.wikimedia.org/w/index.php?curid=11245361]

[https://commons.wikimedia.org/w/index.php?curid=11245361]

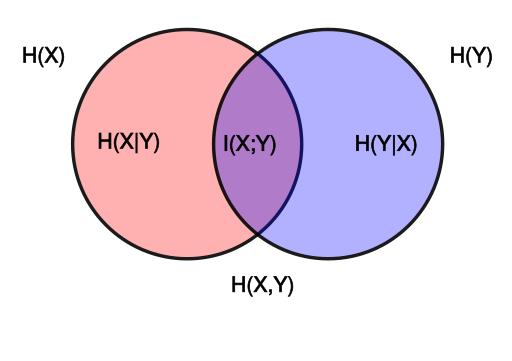

互信息的一些性质包括:

- 非负性:I(X;Y)≥0

- 对称性:I(X;Y)=I(Y;X)

- 衡量依赖于 X 和 Y

- 当且仅当 X 和 Y 相互独立(记为 X⊥Y),I(X;Y)=0

- I(X;Y) 不仅随 X 和 Y 的依赖性而增加,而且随 H(X) 和 H(Y) 的依赖性而增加

- I(X;X)=H(X)−H(X∣X)=0

[https://commons.wikimedia.org/w/index.php?curid=11245361]

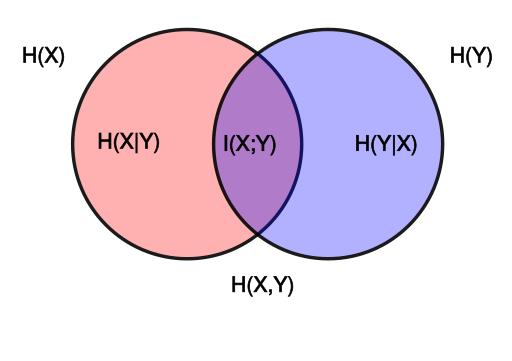

[https://commons.wikimedia.org/w/index.php?curid=11245361] [https://commons.wikimedia.org/w/index.php?curid=11245361]

[https://commons.wikimedia.org/w/index.php?curid=11245361]